¿Podría un deepfake desatar la III Guerra Mundial?

Tiempo de lectura aprox: 3 minutos, 19 segundos

¿Cómo podría comenzar la Tercera Guerra Mundial? Imagínese un video donde el presidente ruso Vladimir Putin anuncia el lanzamiento de misiles nucleares contra Estados Unidos. El ejemplo no es real… pero puede ser probable.

El desarrollo de la inteligencia artificial permite hoy editar falsas representaciones de personas que aparentemente son reales y facturar así un producto que puede resultar muy convincente, a partir de algoritmos sumamente sofisticados y videos o imágenes ya existentes.

A los peligros que entraña el empleo de ese programa informático —conocido como deepfake— en una volátil coyuntura internacional donde la paz se halla constantemente retada, se refiere un interesante documental producido por el servicio de radiodifusión alemán Deutsche Welle (DW ), cuyo título es el que precisamente encabeza este artículo.

El audiovisual muestra ejemplos del empleo de deepfakes en contextos tan actuales como la guerra de Ucrania, cuyo presidente Volodomir Zelensky se dirigió a sus conciudadanos a mediados de marzo de 2022 para pedirles que depusieran las armas y se rindieran a las tropas rusas.

Esa alocución nunca sucedió realmente, pero cientos de miles de personas pudieron verla en las redes sociales.

Henry Ajder, un destacado experto en deepfake consultado por los realizadores del documental, consideró que la calidad del producto comunicativo en cuestión era bastante mala, pero que el episodio en sí era ya un síntoma de que hechos como ese podrían ocurrir con más frecuencia y realismo de lo que hasta ahora se ha visto.

Altos cargos y personalidades de la política son precisamente los más propensos a convertirse en víctimas de ese método de manipulación mediática que parte del aprendizaje automático y la creación autónoma de material multimedia.

Y lo son en la medida en que su proyección pública genera videos y fotos que constituyen la materia prima de los modelos de inteligencia artificial para entrenar y mejorar la clonación de esas personas.

El documental muestra el ejemplo de una alocución de la excanciller alemana Ángela Merkel, cuyo rostro se intercambia en determinado momento con el del expresidente de los Estados Unidos, Donald Trump. También se ve al expresidente argentino Mauricio Macri durante un discurso con sus facciones transformadas en las de un actor que interpreta a Adolf Hitler.

Para demostrar lo lejos que se ha llegado con la posibilidad de crear falsas imágenes indistinguibles de la realidad, el audiovisual alemán expone un experimento del Centro de Virtualidad Avanzada (Mit Center For Advanced Virtuality) de Massachusetts, Estados Unidos, pionero en experiencias innovadoras con tecnologías de inteligencia artificial.

Se trata de un video del expresidente norteamericano Richard Nixon que sintetiza sus expresiones y su voz para crear un discurso falso sobre la supuesta muerte de los famosos astronautas del Apolo 11.

Eso nunca sucedió. El Apolo 11 fue una misión exitosa. Nadie murió y Nixon nunca pronunció ese discurso. Pero el desenvolvimiento del exmandatario en el audiovisual resulta tan convincente como inquietante, solo de pensar hasta donde la realidad puede quedar suplantada por la virtualidad.

Aunque más vulnerables, no son solo las figuras políticas las más expuestas a la manipulación de su imagen. Puede también sucederle a la gente común, sobretodo a quienes suelen protagonizar un profuso contenido gráfico y audiovisual en sus perfiles en redes sociales, que de hecho se convierten en base de datos del modelo para poder crear imágenes falsas.

¿Pueden prevenirse los deepfakes?

Para Henry Ajder, el perito cosultado por DW para este documental, el peor de los casos sería que los deepfakes alcanzaran tal nivel de fotorrealismo y calidad que no se tuviera ningún criterio para dilucidar si un video es real o no.

Considera el experto que aunque no se ha llegado a ese extremo, puede ser un escenario probable, y no descarta que se alcance ese nivel de calidad en un futuro próximo.

Pero la buena noticia es que la tecnología también avanza para detectar los deepfakes y otras aviesas transformaciones de una imagen original.

El propio especialista explica cómo se les puede identificar entrenando un algoritmo para captar señales en fotos, videos o audios que ni el ojo ni el oido humanos pueden percibir. La recepción está mejorando, pero todavía no se puede confiar en ella para casos extremos.

Otra solución sería la verificación de medios sospechosos. Al respecto recomienda autentificar esas imágenes cuando se captan y luego rastrear su procedencia y su evolución, para determinar en qué punto fueron manipuladas.

Es un recurso conocido como “búsqueda inversa de imágenes” mediante herramientas de revisión como TinEye. Con solo subir el archivo dudoso a esa plataforma, se puede comprobar si la foto ya se ha publicado y en caso afirmativo, en qué web.

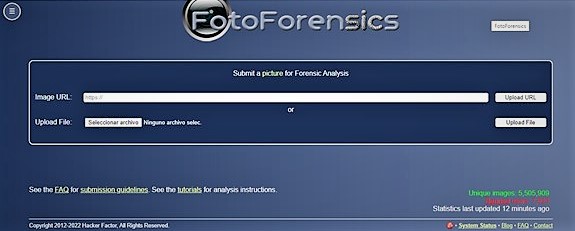

Otro sitio de verificación, el Foto Forensics, permite también identificar la alteración de una imagen mediante la detección en ella de calidades diferentes que puedan evidenciar una manipulación. Este sitio web utiliza técnicas de la fotografía forense para rastrear posibles alteraciones.

Los metadatos contienen la información textual sobre la producción de cualquier archivo multimedia, incluidos los programas de edición utilizados, lo que permite detectar cualquier intervención en esos registros.

En aquellos productos audiovisuales menos elaborados, el común de los internautas puede detectar el engaño en la manera en que se inserta el rostro en la cabeza del busto parlante, en la sospechosa uniformidad de la luz y en el movimiento de los labios a la par del sonido, aspectos que nos muestran las limitacione que aún tienen los deepfakes para replicar con realismo a los seres humanos.

Es posible que aún estemos bastante lejos de que un deepfake pueda desencadenar la Tercera Guerra Mundial. Pero en la Cuarta, ya se emplea esa tecnología.

Porque uno de los aspectos de la doctrina militar conocida como Guerra de Cuarta Generación basa sus estrategias no convencionales de combate en el ciber espacio, y desde ya nos alerta sobre la necesidad de estar atentos, informarnos por fuentes confiables y ser tan concientes de los avances tecnológicos como de los peligros de su manipulación.

Visitas: 2