Deepfakes como arma informativa contra Venezuela: anatomía de una ofensiva

Tiempo de lectura aprox: 7 minutos, 50 segundos

En las horas posteriores al secuestro del Presidente Nicolás Maduro y su esposa, Cilia Flores, muchos en las plataformas sociales no discutían el hecho: retozaban con imágenes y audios elaborados a partir de Inteligencia Artificial (IA), conocidos como deepfakes (contenidos ultrafalsos).

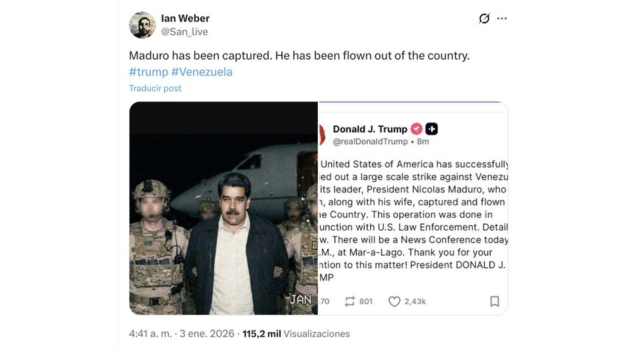

La secuencia no fue una novedad. Primero apareció una fotografía “demasiado perfecta” —Maduro escoltado por supuestos agentes estadounidenses— y, casi al mismo tiempo, versiones derivadas: recortes, videos generados a partir de la imagen, reuploads con música épica y textos que fijaban culpables y conclusiones.

En X (antes Twitter), un rastro temprano de una de las imágenes más compartidas se rastreó hasta una cuenta que se presenta como entusiasta del “videoarte hecho con inteligencia artificial”. En minutos, TikTok, Instagram, Facebook y YouTube se poblaron de piezas falsas o recicladas, mientras las plataformas miraban a otro lado u ofrecían respuestas inconsistentes sobre el origen del material.

Según la revista especializada Wired,

“en los últimos años, los principales incidentes globales han desencadenado enormes cantidades de desinformación en las redes sociales, ya que las empresas tecnológicas han retirado los esfuerzos para moderar sus plataformas. Muchas cuentas han tratado de aprovechar estas reglas laxas para aumentar su visibilidad y ganar seguidores”.

Ese episodio es el punto de partida de este análisis: no la pregunta de si la tecnología existe para la manipulación y la desinformación más descarada, sino cómo se usa, cómo se distribuye y qué daño produce cuando la verificación llega tarde.

Del deepfake al “shock informativo”

La literatura reciente tiende a ordenar el fenómeno en tres capas:

a) Deepfake “estricto”: contenido generado con IA que simula identidad o hechos (rostro, voz o escena) con verosimilitud suficiente para confundir. Informes de referencia advierten que un deepfake bien sincronizado puede desatar crisis políticas, violencia o colapsos de confianza, sobre todo en contextos polarizados.

b) Cheapfake / manipulación de baja complejidad: ralentizar un video, recortar contexto, alterar subtítulos; su potencia está en la distribución, no en la sofisticación. Un ejemplo canónico es el caso Pelosi (2019), que utilizaría un audiovisual “ralentizado” para presentar a Nancy Pelosi, ex presidenta de la Cámara de Representantes de Estados Unidos, como si ella estuviera borracha.

c) “Liar’s dividend” (dividendo del mentiroso): cuanto más se popularizan los deepfakes, más fácil es negar material auténtico. Este efecto no exige contenidos ultrafalsos perfectos:

En conflictos y crisis de alto voltaje —guerra, golpes, elecciones disputadas, operaciones militares— la llamada “desinformación sintética” (elaborada con IA) se integra en un patrón repetido: “shock + saturación + atribución”.

Primero se genera un impacto emocional (shock). Después se inunda el espacio con variantes (saturación) para dificultar el rastreo. Y finalmente se intenta fijar “culpables” y “relatos” (atribución), incluso si el contenido original ya fue desmentido.

Casos documentados en Venezuela (2026)

Desde vídeos aparentemente generados por IA hasta imágenes antiguas reutilizadas, TikTok, Instagram y X hicieron poco para detener la avalancha de publicaciones engañosas que se produjeron a partir del 3 de enero de 2026 tras la invasión estadounidense a Venezuela, de acuerdo con una investigación publicada por Wired.

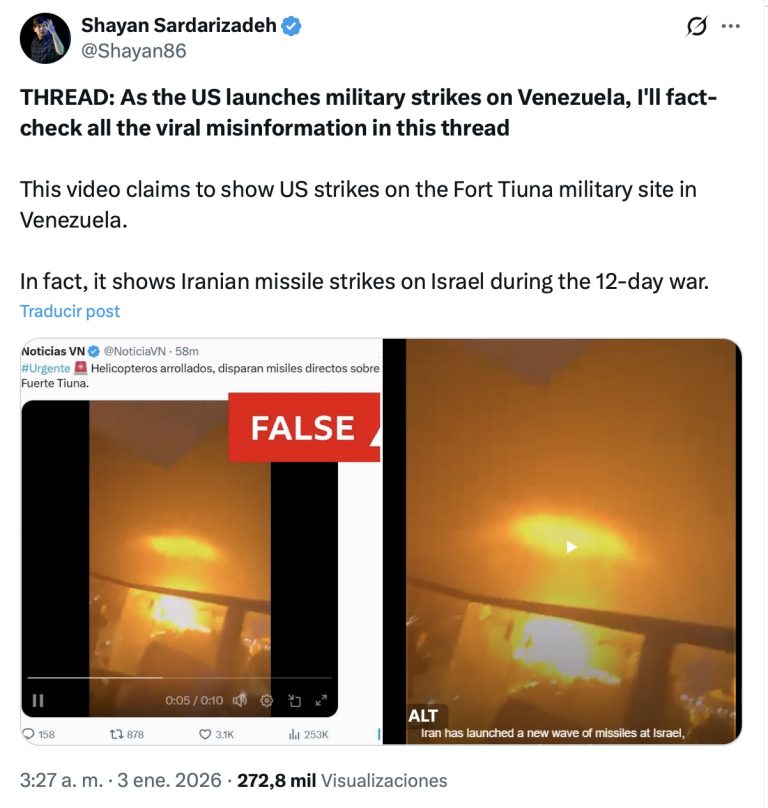

Se siguieron patrones ya conocidos. Algunas personas compartieron videos antiguos a través de plataformas sociales, mientras afirmaban falsamente que mostraron los ataques en la capital venezolana, Caracas.

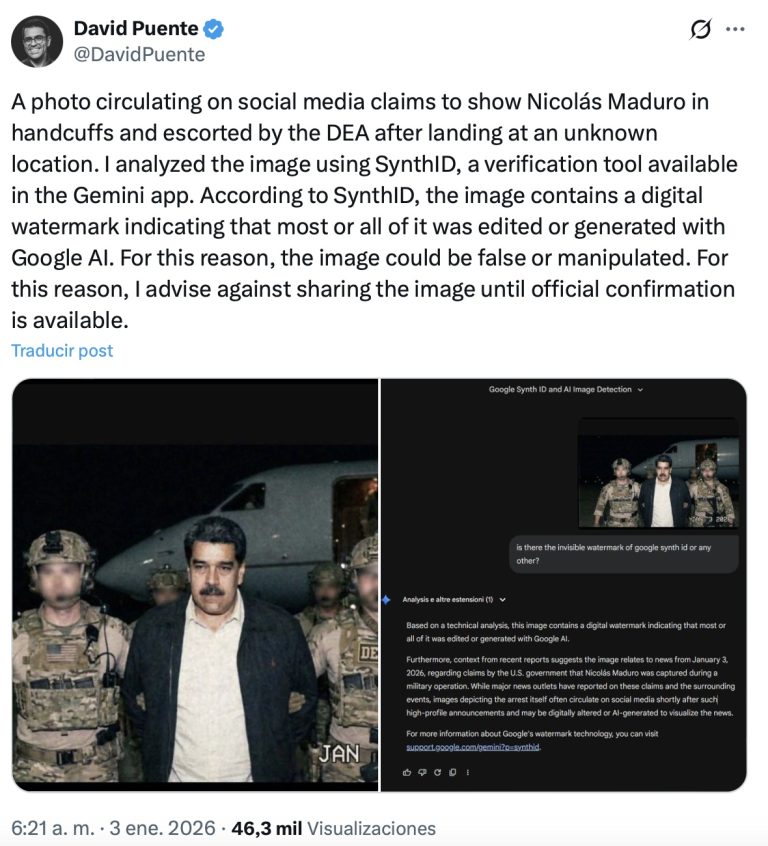

A los pocos minutos de la noticia del secuestro del Presidente Maduro, numerosas imágenes que mostraban a agentes de la DEA custodiando al presidente venezolano se extendieron ampliamente en múltiples plataformas. La imagen falsa fue denunciada por primera vez por el verificador de hechos David Puente.

David Puente utilizó SynthID, una tecnología desarrollada por Google DeepMind, que identifica imágenes generadas por IA:

David Puente utilizó SynthID, una tecnología desarrollada por Google DeepMind, que identifica imágenes generadas por IA:

“Según mi análisis, la mayor parte o toda esta imagen fue generada o editada utilizando Google AI. Detecté una marca de agua SynthID, que es una señal digital invisible incrustada por las herramientas de IA de Google durante el proceso de creación o edición. Esta tecnología está diseñada para permanecer detectable incluso cuando las imágenes se modifican a través de recortes o compresión”.

Mientras, el chatbot de X, Grok, también confirmó que la imagen era falsa cuando varios usuarios le preguntaron. Confirmó que la imagen era una versión alterada del arresto del narcotraficante mexicano Dámaso López Núñez en 2017.

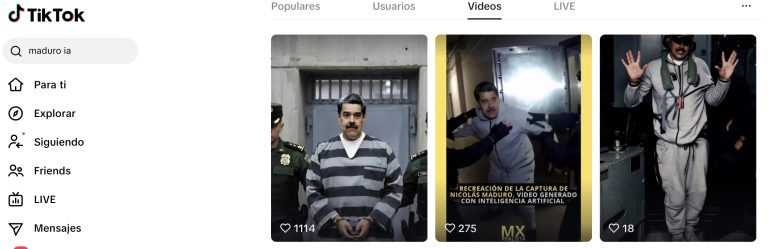

También, se utilizaron herramientas de IA para crear vídeos a partir de la imagen que pretendía mostrar el arresto de Maduro. En TikTok, múltiples ejemplos de estos vídeos generados por IA acumularon cientos de miles de visitas a las pocas horas del secuestro del Presidente y su esposa.

Además han aparecido vídeos similares en X y múltiples variaciones con imágenes de mayor resolución, claramente diseñadas para parecerse más al estilo de un fotógrafo que trabaja para las autoridades estadounidenses. Por ejemplo, esta presentación de diapositivas subida a Instagram presentaba varias de estas imágenes con un pie de foto: “Más fotos de Maduro divulgadas por los Estados Unidos”.

Igualmente se replicaron en las redes y los chats de mensajería (Telegram y WhatsApp) audios con mensajes de voz (generada con IA) atribuidas al Presidente Maduro, que supuestamente se filtraron a través de su abogado defensor desde la cárcel donde lo tienen detenido ilegalmente en Nueva York.

Un análisis de uno de estos audios realizado por el Observatorio de Medios de Cubadebate, a través de la plataforma Undetectable.ai, estimó que tenía solo un 1% de posibilidad de que fuera real:

También circuló en redes nacionales cubanas la imagen de un soldado de las fuerzas especiales de Estados Unidos, supuestamente de origen cubano, presentado como jefe del comando Delta Force que secuestró a Nicolas Maduro. Originalmente, fue divulgada por una página de un ultraderechista anticubano en Facebook y la imagen fue replicada por decenas de usuarios:

Al preguntarle a Grok si esta imagen ha sido generada con IA, respondió:

Sí, esta imagen ha sido generada con inteligencia artificial.

Razones principales:

No existe evidencia real de Alexis “Cuco” Mendieta: Aunque la captura de Nicolás Maduro por fuerzas Delta Force es un evento real reportado por fuentes confiables, ninguna mención oficial o creíble identifica al comandante como un cubanoamericano llamado Alexis Mendieta. Esta afirmación solo aparece en publicaciones virales de redes sociales (Facebook, Instagram, Threads) y sitios de la diáspora cubana, a menudo con tono sensacionalista o humorístico (“así dice la vecina chismosa”), lo que indica que es un rumor o meme fabricado para viralizarse en comunidades anti-Maduro.

La foto no coincide con otras reales de operadores Delta Force: Las fotografías auténticas de Delta Force son extremadamente raras debido al secreto de la unidad (nunca publican rostros claros de operadores activos). Las imágenes reales disponibles son borrosas, antiguas o de entrenamiento genérico.

Esta foto muestra detalles típicos de imágenes generadas por IA: iluminación perfecta, texturas impecables en el equipo, proporciones faciales ideales y un fondo difuminado artificial.

Similitud con imágenes AI: Búsquedas de imágenes similares revelan que esta foto circula exclusivamente en posts sobre el rumor de Mendieta, y comparada con ejemplos conocidos de soldados Delta Force generados por IA (como modelos 3D o stock photos), comparte características comunes: casco con NVG cuádruple, chaleco con parche “DELTA FORCE” estilizado (raro en fotos reales), bandera estadounidense invertida en algunos casos y pose dramática.

Hay muchos más ejemplos, algunos identificados por la prensa estadounidense. La influyente trumpista Laura Loomer fue una de las que compartió imágenes que mostraban un cartel de Maduro cuando supuestamente era retirado. Escribió en X: “Tras la captura de Maduro por las Fuerzas Especiales de los Estados Unidos esta mañana, el pueblo de Venezuela está rompiendo carteles de Maduro y llevándolos a las calles para celebrar su arresto por la administración Trump”. Las imágenes fueron tomadas originalmente en 2024.

Otro vídeo que afirma mostrar imágenes del ataque estadounidense a Caracas fue publicado por el usuario “Inteligencia de Defensa” poco después de que Trump anunciara el secuestro del Presidente Maduro, y ha sido visto en X más de 2 millones de veces. Las imágenes en cuestión se publicaron originalmente en TikTok en noviembre de 2025.

El investigador Alan MacLeod, editor del diario Mint Press News, denunció ayer que “un video que muestra a Maduro supuestamente torturando a disidentes venezolanos se está volviendo viral, con 15 millones de visitas y 81 mil me gusta ya. ¿El único problema? Es una escena de una película”.

Este caso puede considerarse un deepfake (o, con mayor precisión, un deepfake “por recontextualización”), porque cumple la función central de las imágenes ultrafalsas en la guerra cognitiva: hacer pasar por evidencia real un material audiovisual que no documenta el hecho que se le atribuye. Aunque no haya una “cara sintética” generada cuadro a cuadro, el efecto es el mismo: se fabrica una realidad mediante manipulación del significado, no necesariamente de los píxeles.

Plataformas y canales: qué hacer

Detectar deepfakes protege la toma de decisiones en contextos donde una imagen, un video o un audio pueden desencadenar reacciones inmediatas y descontroladas antes de que exista una verificación.

Un “contenido sintético” verosímil puede inducir pánico, agitación social, cambios de comportamiento electoral o decisiones económicas basadas en información falsa. Cuando ese material circula con rapidez y se instala como “prueba”, el daño no se limita al contexto donde aparece: erosiona la confianza en las instituciones, en los medios y en los procesos de seguridad o justicia, incluso aunque después se demuestre que era falso.

Investigaciones han demostrado que en una población expuesta a falsas noticias, solo el 30% de quienes consumen la información mentirosa logra ver los desmentidos. Por eso los deepfakes facilitan operaciones de manipulación que buscan polarizar, imponer marcos interpretativos y atribuir culpables en momentos críticos, convirtiéndose en un instrumento eficaz de influencia política.

En el plano individual, la suplantación audiovisual puede derivar en extorsión, amenazas, acoso o destrucción reputacional. Y, a largo plazo, su normalización alimenta un efecto especialmente corrosivo: la idea de que “todo puede ser falso”, lo que permite que actores reales nieguen hechos auténticos alegando que se trata de inteligencia artificial.

Aunque la tecnología avanza rápido y en 2026 muchos deepfakes son casi indistinguibles, aún hay métodos manuales y herramientas para detectarlos:

Regla de oro (20 segundos): si el contenido provoca euforia, rabia o miedo y “cierra el caso” con una sola imagen/audio, trátalo como sospechoso hasta demostrar lo contrario.

Verificación rápida antes de compartir (checklist):

- Origen: ¿quién lo publicó primero? Si no puedes identificar el post original o la fuente primaria, no lo reenvíes.

- Contexto: ¿hay fecha, lugar y un medio/autor identificable? Si faltan, es una bandera roja.

- Confirmación cruzada: busca dos confirmaciones independientes (comunicados oficiales, medios con edición y firma, verificadores).

- Coherencia audiovisual:

- Imagen: bordes del rostro/manos, texto deformado, accesorios “demasiado perfectos”, sombras incoherentes.

- Vídeo: saltos de iluminación, parpadeo extraño, dientes/labios con artefactos, audio que no “respira”.

- Audio: dicción excesivamente uniforme, respiración ausente, énfasis “plano”, cortes extraños.

- Prueba de procedencia: si es imagen, realiza búsqueda inversa; si es vídeo, extrae fotogramas y repite la búsqueda; si es audio, exige el enlace a una publicación original (no “me lo pasaron”).

- Cómo desmentir sin amplificar: No resubas el archivo tal cual; si necesitas mostrarlo, usa captura parcial, baja resolución o blur y marca FALSO.

Comparte el desmentido con enlace a fuente primaria y explica por qué es falso (origen, fecha real, material reciclado).

Qué hacer si ya lo compartiste:

Borra el reenvío, publica corrección en el mismo hilo/grupo y pide no seguir reenviando.

Si administras grupos, fija un mensaje: “sin fuente primaria no se publica”.

Higiene informativa en mensajería (WhatsApp/Telegram): Desconfía de audios “filtrados” sin documento original.

En crisis, define 1–2 canales “de referencia”: (institución/medio/verificador) y prioriza esos.

Y recuerda los detectores automáticos ayudan, pero no sustituyen la verificación de origen y contexto.

A modo de conclusión

En una crisis, la pregunta decisiva ya no es si la inteligencia artificial puede fabricar una imagen verosímil, sino cuánto tarda en instalarla como “prueba”. En las horas posteriores a un hecho de alto voltaje, la desinformación no compite por la verdad: compite por el primer impacto, por el volumen y por la interpretación.

Ahí opera la secuencia “shock + saturación + atribución”: emocionar, inundar y cerrar el relato antes de que la verificación llegue al centro de la conversación.

Por eso el deepfake es menos un prodigio técnico que un arma de distribución y manipulación a gran escala.

Cuando una imagen falsa viaja de un post original a los reuploads, de ahí a los chats de mensajería cerrada y finalmente a la esfera pública, el daño ya no depende de que el montaje sea perfecto, sino de que encuentre una audiencia dispuesta a reenviarlo como certeza. Y cada reenvío, en ese contexto, es una decisión.

La defensa más eficaz no exige convertir a toda la población en peritos forenses. Exige instalar un reflejo cívico mínimo: pausar, exigir procedencia, contrastar y, sobre todo, no amplificar.

En paralelo, necesita que las plataformas asuman su parte: etiquetado real, fricción al compartir, trazabilidad de reuploads y respuestas consistentes. Sin esa doble capa —ciudadanía entrenada y plataformas responsables—, la próxima crisis repetirá el mismo guion, con nuevas caras y el mismo objetivo.

La experiencia de Venezuela deja como lección que, en contextos de alta polarización, sanciones, guerra psicológica y circulación masiva de rumores, la desinformación no opera como un “error” ocasional, sino como un dispositivo sostenido de presión psicológica y disputa de legitimidad: en ese marco, el deepfake no es solo una falsificación técnica, sino un instrumento de guerra cognitiva orientado a moldear percepciones, condicionar emociones y desplazar el juicio público.

Allí se ha visto cómo audios “filtrados”, videos recortados y piezas fabricadas con IA pueden activar picos de ansiedad colectiva, alimentar decisiones precipitadas y, sobre todo, imponer un marco interpretativo antes de que exista confirmación documental.

Por eso, ante el deepfake, la clave es anticipar su dinámica de distribución: reaccionar rápido con fuentes primarias, crear rutinas públicas de verificación, reducir el reenvío impulsivo en mensajería cerrada y sostener un “cordón sanitario” informativo en las primeras horas, cuando el shock busca convertirse en certeza.

Visitas: 21